互联网存储架构的演进始终围绕一个核心矛盾展开:中心化控制与去中心化需求之间的张力。HTTP协议虽支撑了现代网络的基础通信,但其位置寻址机制导致数据获取依赖特定服务器,带来效率瓶颈、容灾能力弱及隐私安全隐患等问题。IPFS作为分布式存储方案,通过内容寻址机制重构数据访问逻辑,打破传统请求-响应模式的局限,标志着从“位置”到“内容”的范式转移。

在这一背景下,IPFS被提出作为构建“终极存储系统”的候选方案。评判此类系统的标准应涵盖安全性、可用性、不可篡改性、扩展性以及激励机制设计等多个维度。本文将基于这些核心指标,系统性解析IPFS的技术特性及其在区块链生态中的应用潜力。

传统HTTP协议的结构性缺陷解析

请求-响应模式的底层工作机制

HTTP协议采用经典的客户端-服务器模型,其核心机制是基于请求-响应的交互流程。客户端(如浏览器)向指定服务器发起资源请求,服务器接收请求后检索并返回对应数据。这种同步通信方式在早期互联网环境中具备实现简单、管理集中的优势,但随着数据规模和用户需求的增长,其固有局限性逐渐显现。由于每次访问均需建立独立连接,网络负载随并发请求数量增加而上升,导致中心化服务器易成为性能瓶颈。

集中式存储引发的安全隐私风险

集中式架构使数据高度依赖单一控制点,一旦服务器遭受攻击或发生故障,整个系统的可用性和安全性将受到严重影响。以Facebook数据泄露事件为例,超过8700万用户信息因平台API接口设计漏洞被第三方非法获取,暴露出中心化存储在权限控制与数据隔离方面的薄弱环节。此外,用户数据的所有权与访问路径均由平台掌控,缺乏透明度,进一步加剧了隐私泄露和滥用风险。

位置寻址导致的效率瓶颈与容灾缺陷

HTTP采用基于位置的寻址机制,即通过URL定位特定服务器上的资源。该机制要求用户必须访问原始服务器获取数据,即使相同内容可能在物理更近的节点上存在副本。这不仅增加了跨区域传输延迟,也降低了整体网络效率。同时,若原始服务器宕机或链接失效,资源将无法访问,形成“单点故障”问题,影响系统的鲁棒性与容灾能力。

IPFS分布式存储的核心机制解密

1. 内容寻址技术的数学原理与哈希指纹机制

IPFS(星际文件系统)采用内容寻址(Content Addressing)替代传统HTTP的位置寻址(Location Addressing),其核心在于利用加密哈希函数生成唯一的内容标识符。每个文件在上传至IPFS网络时,都会通过SHA-256等算法计算出一个固定长度的哈希值,该值可视为文件的“数字指纹”。这种机制确保了即使文件内容发生微小变化,也会导致哈希值的显著差异,从而实现内容的精确识别和完整性验证。相比基于URL的地址体系,内容寻址从根本上消除了对服务器位置的依赖,提升了数据访问的安全性和效率。

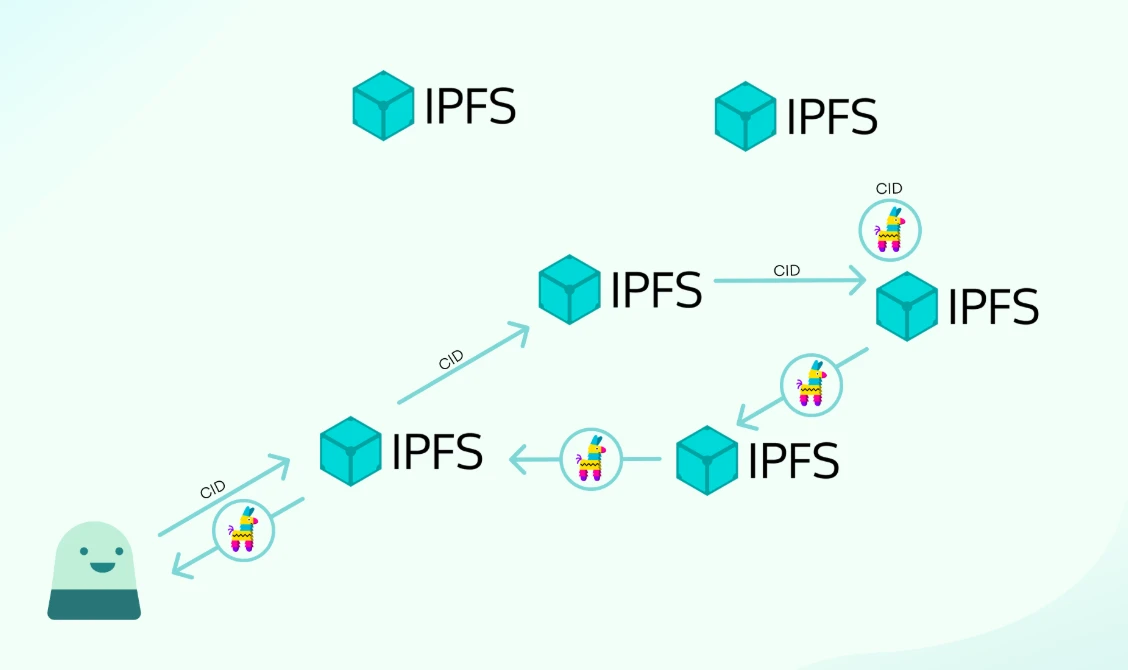

2. P2P网络中的数据分发与节点协作模式

IPFS构建于点对点(Peer-to-Peer, P2P)网络架构之上,所有节点在逻辑上处于平等地位,共同参与数据的存储与传输。当用户请求某个哈希标识的文件时,网络会自动从最近或响应最快的节点获取数据副本,而非集中式服务器。这种分布式的协作模式不仅提高了数据检索速度,还增强了系统的容错能力。此外,IPFS引入了DHT(分布式哈希表)技术,用于高效定位存储特定内容的节点,进一步优化了网络资源的利用效率。

3. 版本控制系统的不可变特性与数据加速机制

IPFS内置版本控制系统,支持对文件的历史变更进行追踪。每次修改后的内容都会生成新的哈希标识,原有版本则被保留,形成不可篡改的数据链。这一特性与区块链的不可变账本理念高度契合,为数据的真实性和溯源性提供了保障。同时,由于多个节点可以缓存同一内容的副本,IPFS具备天然的内容分发加速能力。随着数据被更多节点缓存,访问延迟降低,整体网络性能得以提升,尤其适用于大规模内容分发场景。

IPFS技术体系的双面性分析

1. 去中心化架构带来的安全性提升与传输效率优化

IPFS(星际文件系统)采用去中心化的P2P网络架构,从根本上改变了传统HTTP协议中依赖中心服务器的数据获取方式。在该模式下,数据通过内容寻址机制进行分发,用户基于哈希指纹直接从最近的可用节点获取数据,而非固定服务器。这种设计不仅降低了单点故障风险,还提升了整体系统的抗攻击能力。此外,由于多个节点可同时提供相同内容,数据传输路径更短、并发能力更强,从而显著提高了访问效率,尤其适用于大规模分布式应用场景。

2. 数据不可变特性引发的更新维护难题

IPFS的内容不可变特性确保了数据的完整性和防篡改能力,但也带来了版本管理和更新方面的挑战。一旦文件被上传并生成哈希标识,任何修改都将产生新的哈希值,意味着原数据无法直接更新。这要求开发者和用户必须建立有效的版本控制系统,并依赖链外机制或附加层(如IPNS)来实现动态内容管理。对于频繁变更的数据场景,如实时数据库或动态网页,这种限制可能影响其实用性。

3. 节点离线风险与存储冗余度的平衡策略

IPFS依赖分布式节点共同维护数据可用性,但节点的非持续在线状态可能导致部分数据暂时不可达。为缓解这一问题,系统需在存储冗余度与资源消耗之间寻求平衡:一方面,提高副本数量可增强容灾能力;另一方面,过度冗余将增加网络负载与存储成本。实践中可通过激励机制(如Filecoin)鼓励节点长期参与,结合智能调度算法优化数据分布,从而在保障可用性的同时维持系统效率。

区块链与IPFS融合的创新实践

1. DCore平台的混合架构实现路径

DCore区块链通过将IPFS集成至其底层架构,构建了一种去中心化内容分发网络。该平台采用混合架构设计,利用IPFS进行大规模数据存储,同时借助区块链记录元数据和时间戳信息。这种结构有效分离了计算与存储职责,使IPFS承担静态内容的高效分发任务,而区块链则确保数据来源的真实性与不可篡改性。

2. 区块链时间戳验证与IPFS存储的协同机制

在DCore系统中,每次上传的内容都会生成唯一的哈希指纹,并通过区块链加盖时间戳。这一机制不仅保障了内容的原始归属权,还为后续的数据验证提供了可审计路径。IPFS负责内容的分布式存储与快速检索,而区块链则作为信任锚点,二者形成互补关系,共同构建可信的数据生命周期管理体系。

3. 激励层设计对节点持续性的保障作用

为了维持IPFS节点的长期在线率与数据可用性,DCore引入基于区块链的激励机制。节点运营商因持续提供存储空间和带宽资源而获得代币奖励,从而形成经济驱动的可持续网络生态。该设计有效缓解了纯IPFS网络中节点不稳定的问题,提升了整体系统的鲁棒性与服务质量。

分布式存储的未来演进方向

Web3.0基础设施的范式重构

随着Web3.0概念逐步落地,分布式存储正成为新型互联网基础设施的核心组件。传统中心化架构难以满足去信任化、数据主权和隐私保护等关键需求,而IPFS等分布式存储协议通过内容寻址机制重构了数据定位与获取方式,为构建更具弹性和透明度的网络层提供了技术基础。

内容分发产业的技术赋能路径

在数字内容分发领域,分布式存储显著优化了大规模数据传输效率,并通过节点冗余机制提升服务可用性。结合激励机制设计,可有效调动全球闲置存储资源,形成可持续扩展的内容交付网络(CDN),从而降低传统流媒体、软件分发等场景下的带宽成本与中心化依赖风险。

可扩展性挑战与Layer2解决方案的适配空间

尽管分布式存储具备显著优势,但其在数据持久性、检索效率及网络吞吐方面仍面临可扩展性瓶颈。对此,基于Layer2的扩展方案如Filecoin的检索市场、状态通道等机制,正在探索更高效的存储验证与数据交换模式,以实现主链减负与性能提升,进一步释放分布式存储体系的规模化应用潜力。