区块链技术的核心创新之一在于其去中心化的账本共识机制。在传统金融或数据系统中,信任通常依赖于中心化机构的背书,而在区块链网络中,这种信任被算法和密码学所取代。共识机制正是实现这一信任转换的关键技术基础,它保障了分布式节点能够在无需互信的前提下达成一致的状态确认。

比特币作为首个成功应用区块链技术的加密货币,采用了工作量证明(Proof of Work, PoW)作为其核心共识机制。通过要求矿工执行计算密集型任务来竞争生成新区块的权利,PoW不仅保障了交易记录的安全性与不可篡改性,还有效防止了恶意攻击者对系统的操控。本文将围绕比特币工作量证明的技术实现展开深入解析,从哈希函数、挖矿流程、难度调整到区块验证等关键环节进行系统性探讨,揭示其背后的数学原理与工程实践。

工作量证明的基本原理与技术基础

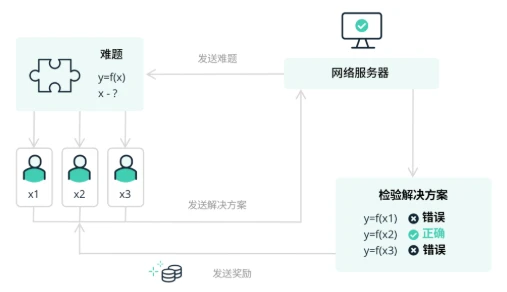

在比特币的工作量证明(Proof of Work, PoW)机制中,SHA-256哈希函数是整个系统安全性的核心组件。该函数将任意长度的输入数据映射为固定长度的256位输出值,并具备单向性、抗碰撞性和雪崩效应等密码学特性。矿工通过不断调整区块头中的nonce参数,对区块头进行SHA-256运算,以寻找满足目标阈值的哈希值。这一过程构成了挖矿的核心计算任务。

区块头由版本号、前一个区块哈希、Merkle根、时间戳、难度目标(Bits)和nonce组成。其中,nonce是一个32位的可变整数,其取值范围决定了矿工每次哈希计算的尝试次数。由于SHA-256的不可预测性,矿工必须通过大量试错来找到符合要求的nonce值,从而保障计算资源的实质性投入。

目标阈值(Target Threshold)是哈希值需低于或等于的数值,它由当前难度值(Difficulty)决定。只有当计算出的哈希值小于等于该目标值时,该区块才被视为有效,进而被网络接受。这种基于数学约束的设计,使得工作量证明具备了可验证性与公平性。

挖矿流程的完整技术实现

1. 区块构造阶段的交易打包机制

比特币挖矿的第一步是区块构造,其核心在于交易打包。每当一个新区块被提议时,矿工会从内存池中选取未确认的交易,并按照手续费高低和优先级进行排序。这些交易经过验证后被打包进区块体(Block Body),形成该区块所承载的交易集合。同时,为确保交易数据的完整性与不可篡改性,系统会为这些交易构建Merkle树结构。

2. Merkle树构建与区块头组合过程

在交易完成打包后,矿工需将所有交易通过双重SHA-256哈希运算构建成一棵Merkle树。这棵树的根节点(Merkle Root)作为区块头中的关键字段之一,用于高效验证交易是否存在且未被篡改。区块头还包括前一区块的哈希值、时间戳、难度目标(target)、nonce以及版本号等信息。这一组合过程不仅决定了区块的唯一性,也为后续哈希计算奠定了基础。

3. ASIC矿机参与的哈希计算循环

区块头组装完成后,矿工便开始执行工作量证明的核心操作:不断调整nonce值并计算区块头的SHA-256哈希值,以期找到满足当前难度目标的小于特定阈值的哈希结果。由于这一过程需要极高的计算能力,现代矿工普遍采用专用集成电路(ASIC)矿机来执行。ASIC矿机具备高吞吐量、低能耗比的优势,使其在哈希计算循环中占据主导地位。一旦某个矿工率先找到符合条件的nonce,他将立即广播该区块至全网,进入验证与共识阶段。

难度调整机制的动态平衡设计

2016区块周期的难度重计算规则

比特币网络通过每2016个区块进行一次难度调整,以维持平均出块时间在10分钟左右。这一机制的核心在于根据前一周期的实际出块时间,动态调整哈希目标阈值。具体而言,若2016个区块的生成耗时少于20160分钟(即10分钟/块),则系统将提高挖矿难度;反之,则降低难度。这种调整通过修改区块头中的难度目标字段实现,直接影响哈希值的有效性判断标准。

全网算力与出块时间的反馈调节

难度调整本质上是对比特币全网算力变化的响应机制。当大量矿机加入网络导致算力上升时,单位时间内哈希计算能力增强,区块生成速度加快,从而触发难度上调。相反,若部分矿机关机或退出,算力下降,系统则会降低难度以避免出块间隔过长。该反馈机制确保了区块链系统的稳定性,使区块生成速率不会因外部算力波动而失控,同时保障交易确认的可预测性。

时间戳偏差对难度调整的影响

每个区块头包含一个时间戳,用于记录区块生成时刻。理论上,时间戳应严格递增且接近真实时间。然而,由于节点间存在时钟差异或人为微调行为,可能导致时间戳出现轻微偏差。若连续多个区块的时间戳被人为拉长或压缩,可能影响2016区块周期的总时长计算,进而造成难度调整失真。为此,比特币协议引入了时间戳验证规则,要求新区块的时间戳必须大于前11个区块的中位数时间,以此限制时间戳操纵对难度机制的干扰。

区块验证与分布式共识达成

1. 节点验证的完整检查清单

当矿工成功挖出新区块并广播至全网后,各节点需执行严格的验证流程。该流程包括:确认区块头哈希值是否低于当前难度目标、验证Merkle根是否正确反映交易列表内容、检查时间戳是否在允许范围内、以及确认前一区块哈希是否指向当前最长链的最新区块。此外,节点还需逐笔校验区块内所有交易的有效性,确保无双重支付或非法输入输出。

2. 孤块与链重组的处理机制

在网络传输延迟或多个矿工几乎同时挖出区块的情况下,可能会产生“孤块”——即未被最终主链采纳的区块。比特币协议通过最长链原则解决这一问题,节点始终选择累积工作量最大的链作为主链。若新接收的区块导致某条分支变得更长,则触发链重组(Chain Reorganization),将原链尾部区块回滚,并切换至新链继续扩展。

3. 最终确定性确认的六区块原则

尽管一个区块一经确认即可被视为有效,但为防范潜在的链重组风险,市场普遍采用“六区块确认”原则来认定交易的不可逆性。经验表明,在算力分布相对去中心的前提下,经过六个后续区块确认的交易几乎不可能被逆转,从而实现事实上的最终确定性(Finality)。这一机制构成了比特币交易安全性的重要保障。

工作量证明的价值维度分析

经济博弈论下的安全防护模型

工作量证明(PoW)机制本质上是一种基于经济激励与资源投入的博弈模型。在比特币网络中,攻击者若试图篡改历史交易,必须掌握超过50%的全网算力,这在现实中意味着极高的硬件与电力成本投入。这种“算力门槛”使得攻击行为在经济上变得极不划算,从而形成天然的安全屏障。矿工通过持续投入算力资源参与区块打包,其行为本身即是对网络诚实性的背书。这种博弈结构确保了理性参与者更倾向于维护系统稳定,而非破坏它。

算力集中化风险的量化评估

尽管PoW机制设计初衷是实现去中心化,但随着ASIC矿机的普及和矿池的兴起,算力集中化趋势日益显著。若少数矿池控制超过30%的算力,理论上即可对网络造成“潜在威胁”。例如,2021年某矿池短暂控制超过40%算力,引发社区对“51%攻击”的担忧。因此,算力分布的集中程度成为衡量PoW网络安全性的重要指标之一。通过哈希算力分布的基尼系数或赫芬达尔指数(HHI)等经济学工具,可对算力集中化程度进行量化评估,从而预警潜在风险。

电力消耗与价值创造的辩证关系

PoW机制因高能耗而饱受争议,但其能源消耗本质上是对网络安全的“定价”。每单位电力的投入,对应的是区块奖励与交易手续费的经济回报。从价值创造角度看,比特币网络通过能源密集型计算过程,构建了一个全球共识的不可篡改账本,其维护成本与系统总市值之间存在某种隐性锚定关系。此外,随着可再生能源在挖矿中的应用比例上升,PoW的能耗问题正逐步向可持续方向演进。电力消耗并非单纯的“浪费”,而是转化为数字资产信任体系的基础设施投入。

技术演进与跨领域应用前景

1. 抗ASIC算法与PoW变种发展

工作量证明(PoW)机制自比特币诞生以来,一直是去中心化网络的核心共识机制。然而,随着专用ASIC矿机的普及,算力逐渐向少数群体集中,威胁到网络的去中心化特性。为应对这一问题,社区和开发者提出了多种抗ASIC算法,如Ethash(以太坊)、RandomX(门罗币)等,旨在通过内存密集型或多样化计算方式降低ASIC优势,提升挖矿的公平性。此外,部分项目尝试对PoW机制进行改良,例如引入可验证延迟函数(VDF),增强时间维度上的不可并行性,从而推动共识机制的进一步演化。

2. 侧链/跨链中的共识机制融合

在多链生态快速发展的背景下,如何实现不同区块链之间的互操作性成为关键技术挑战。侧链与跨链技术通过引入双向锚定、中继链或多签验证等方式,使资产和信息能在不同链之间安全流转。在此过程中,共识机制的融合尤为关键。例如,某些项目采用混合共识模型,在主链使用PoW保障安全性,而在侧链引入权益证明(PoS)或拜占庭容错(BFT)机制提升效率。这种架构不仅保留了PoW的安全优势,也增强了系统的扩展性和灵活性。

3. 物联网设备算力共享的潜在场景

随着物联网(IoT)设备数量激增,其闲置算力资源具备参与分布式计算的潜力。将IoT设备纳入轻量化PoW体系,有望构建去中心化的边缘计算网络。例如,低功耗设备可通过执行微型哈希任务参与区块验证或数据同步,形成“微挖矿”模式。此类方案需优化能耗与安全性平衡,并设计激励机制以鼓励设备贡献资源。尽管目前尚处于探索阶段,但其在分布式存储、实时数据分析等场景中已展现出初步应用价值。